Что такое промт в нейросетях

-

Как правильно: промт или промПт?

-

Зачем нужно учиться составлять промты?

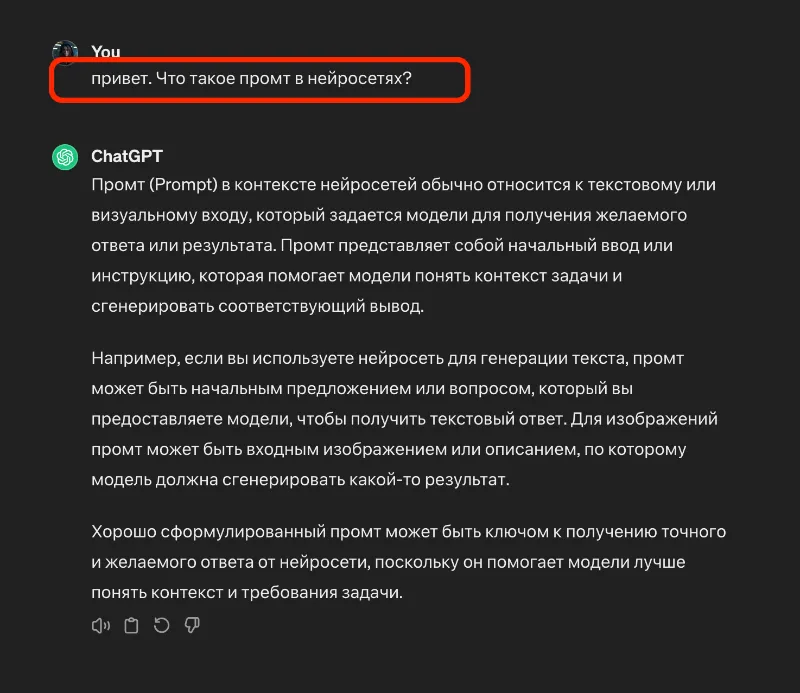

Промт (или «подсказка») – это текст, который вы даете модели искусственного интеллекта (нейронке) для получения ответа. Промт обычно имеет форму вопроса или инструкции.

Как правильно: промт или промПт?

Если кратко, и так, и так. На английском языке этот термин пишется prompt. Формально правильно употреблять именно с буквой «п». Но в русской разговорной речи «промпт» неудобно произносить. Гораздо удобнее «промт». Поэтому это упрощение закрепилось и на письме.

Зачем нужно учиться составлять промты?

Представьте, что вы беседуете с самым умным человеком в мире. Вы задаете ему вопрос, но он отвечает не так, как вы ожидали. Ответ кажется нелогичным (или даже недалеким). Тогда вы задаете этот же вопрос, но более развернуто и с уточнениями. И ваш собеседник дает очень полезный ответ.

Точно так же себя ведут и большие языковые модели (chatGPT, Gemini, Claude, YandexGPT и прочие). Если им задавать конкретный развернутый вопрос, они ответят как самый умный человек в мире.

Золотое правило промта: покажите промт другу и спросите, может ли он следовать инструкциям в нем и получить точный результат, который вы хотите. Если они запутаются, модель тоже даст не тот ответ, который вы ожидаете.

В этой области даже появилась новая наука – промт инжиниринг.

Промт инжиниринг (Prompt engineering) – это эмпирическая наука, которая занимается созданием и тестированием промтов для оптимизации качества ответа. Контентом может быть текст, изображение, видео и любой другой вид медиа. Спрос на вакансии промт-инженера растет каждую неделю.

Кроме этих понятий, пригодится знание еще нескольких терминов из области нейросетей:

Токен – наименьшая отдельная единица языковой модели (нейросети). Токен не равен символу. Он может соответствовать слову, подслову, символам или даже байтам. Например, для английского языка 1 токен приблизительно составляет 3,5 символа, хотя точное количество может варьироваться в зависимости от используемого языка.

Пример:

Фраза «ChatGPT is great!» содержит 17 символов и 6 токенов:

[«Chat», «G», «PT», «is», «great», «!»]

Контекстное окно — простыми словами это «память» модели. У каждой модели есть ограничение на входящее количество символов. Модель использует весь текст, который вы ей отправили, и весь текст, который она сгенерировала до сих пор, чтобы предсказать следующий токен.

Большое контекстное окно позволяет модели понимать более сложные запросы и качетсвенне давать ответы.

Маленькое контекстное окно может ограничить способность поддерживать согласованность при длительных диалогах. Она будет быстро «забывать» суть беседы.