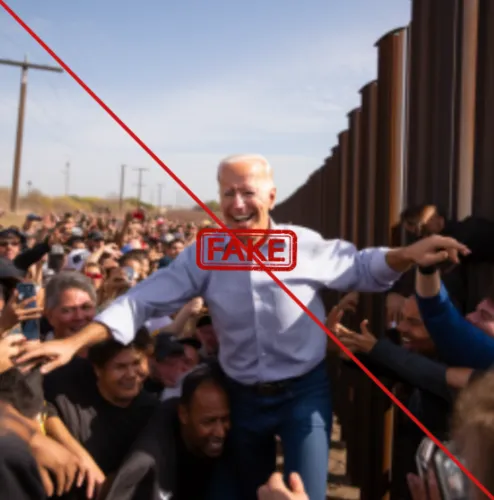

Дипфейки переживают свой ренессанс

В мире более 50 стран, включая США, Россию, Тайвань, Индию и Сальвадор, ждут выборы. Дипфейки, созданные при помощи искусственного интеллекта, переживают свой ренессанс.

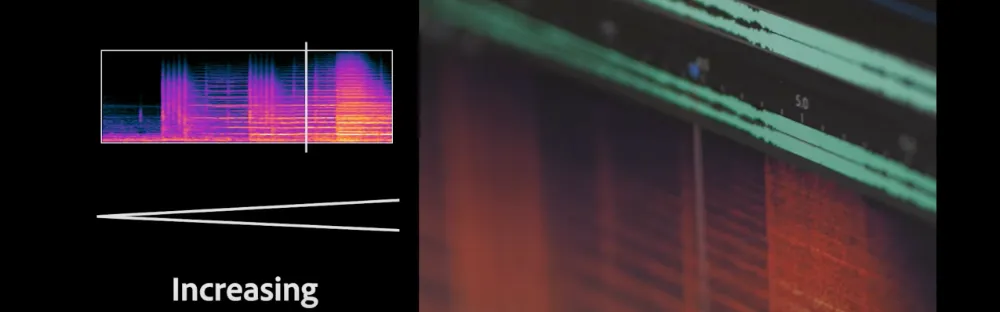

Согласно исследованию CCDH (Центр борьбы с цифровой ненавистью),

объем дезинформации, особенно deepfake-изображений, связанных с выборами, увеличился на 130% в месяц на платформе X (ранее Twitter).

Инструменты искусственного интеллекта позволяют создавать фейки, которые очень трудно отличить от реальных фотографий.

Все больше политиков и общественных организаций выступают за необходимость внедрения мер защиты от дезинформации в инструментах и платформах искусственного интеллекта.

Достается и социальным сетям. По требованию активистов соцсети должны тщательнее модерировать контент и маркировать изображения, созданные искусственным интеллектом.

Некоторые шаги уже предпринимаются и в области законодательства для борьбы с дезинформацией. Крупные технологические компании будут маркировать контент, созданный с помощью искусственного интеллекта. Или вообще запрещать генерировать контент на определенные чувствительные для общества темы, например, политику.

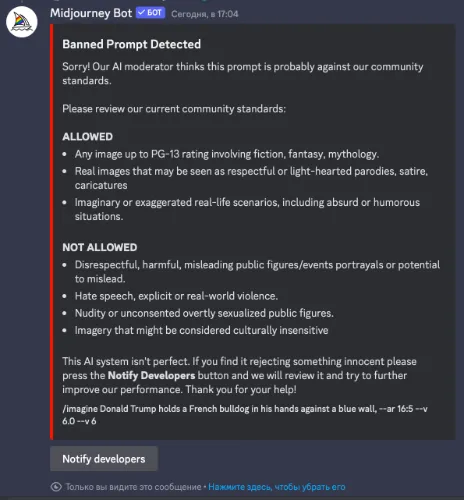

Реальный пример:

Если в Midjourney попросить сгенерировать изображение по промту «Дональд Трамп держит в руках французского бульдога», то бот отвечает:

Обнаружен запрещенный промт

Приносим извинения! Наш ИИ-модератор считает, что этот промт, вероятно, противоречит стандартам нашего сообщества. Пожалуйста, ознакомьтесь с нашими текущими стандартами сообщества:

...Не допускается:

- Неуважительное, вредное, вводящее в заблуждение изображение общественных деятелей/событий или потенциальное введение в заблуждение.

- Разжигание ненависти, явное насилие или насилие в реальном мире.

- Обнаженные публичные персоны...

Несколько крупных площадок запретили политическим кампаниям использовать инструменты искусственного интеллекта в рекламе. Например, Google потребует от политической рекламы, использующей AGI (генеративный искусственный интеллект), явно указывать подобную информации.